Конфіденційність у ШІ: чи справді моделі захищають ваші дані?

Великі мовні моделі (LLM) стали невід'ємною частиною сучасних технологій. Вони працюють у фоновому режимі в додатках, якими ви користуєтеся, навіть зараз, читаючи цей текст.

Автозаповнення в електронних листах, відповіді у чат-ботах, як-от ChatGPT, чи зображення, створені DALL-E, – усе це завдяки мовним моделям.

Джерело: techxplore.com

Деталі:

І всі вони навчені на реальних документах та зображеннях.

Експерт із комп’ютерної безпеки Девід Еванс з Університету Вірджинії разом із колегами нещодавно виявили, що поширений метод перевірки того, наскільки дані, використані для навчання LLM, піддаються розголосу, є менш ефективним, ніж вважалося раніше. Ці результати опубліковані на сервері попередніх друків arXiv.

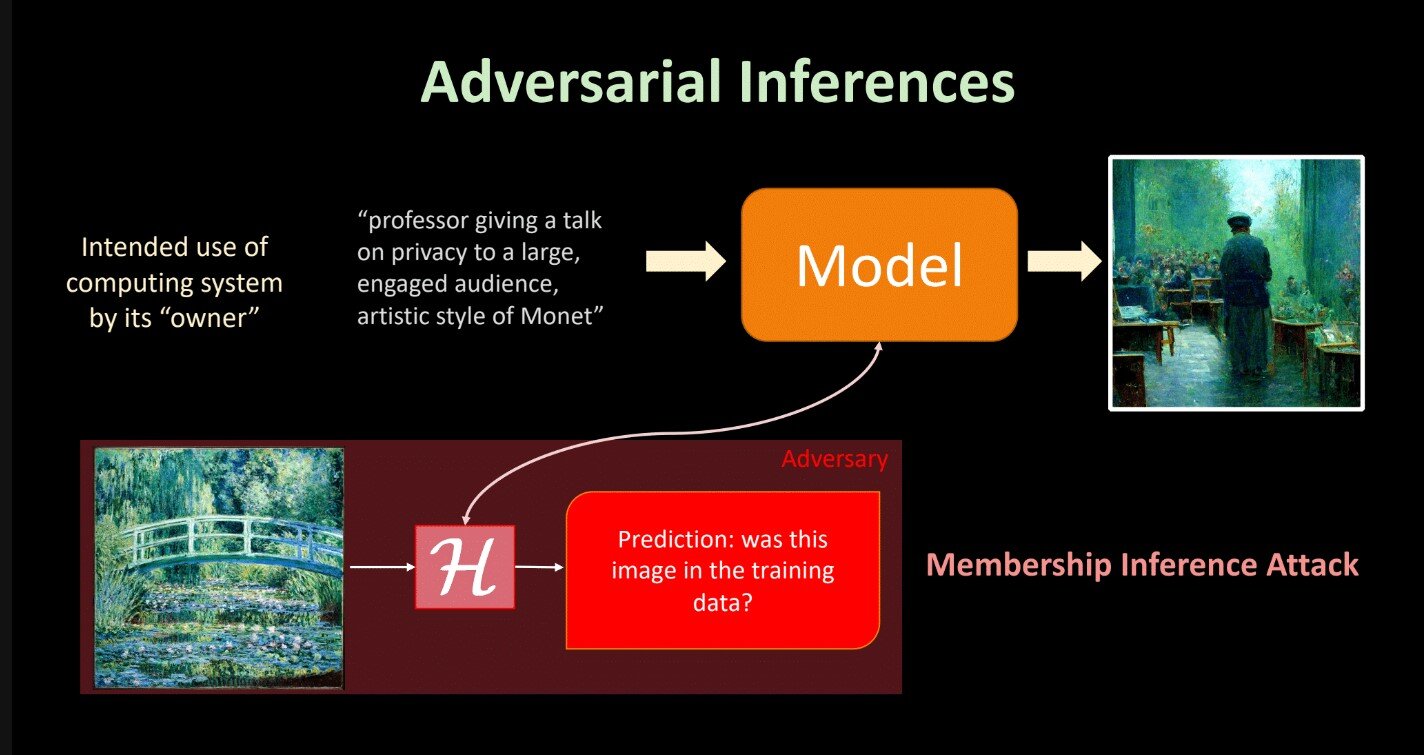

Що таке атака з визначення членства?

Розробники ШІ під час створення мовних моделей збирають величезну кількість тексту, часто зі сторінок інтернету або приватних джерел, таких як електронна пошта. Цей процес важливий для забезпечення безпеки тренувальних даних, які можуть включати особисті тексти чи зображення.

Атаки з визначення членства (Membership Inference Attacks, MIA) – це основний інструмент для перевірки ризиків витоку інформації. За допомогою цих тестів можна визначити, чи модель "запам’ятала" текст із тренувальних даних дослівно.

Еванс пояснює:

"Це спосіб перевірити, наскільки модель розкриває інформацію про конкретні дані, на яких вона навчалася".

Чи ефективні MIA?

Дослідники провели масштабну оцінку п’яти поширених MIA-методів. Усі інструменти працювали на відкритих мовних наборах даних, таких як "The Pile", створений EleutherAI.

Однак результати показали, що методи MIA часто не враховують особливості мови, як-от зміни в значенні текстів через вибір слів. Це ускладнює чітке визначення, чи певний текст був частиною тренувальних даних.

Довідково:

Виявлення ризиків конфіденційності в LLM – складне завдання, яке тільки починають розуміти в спільноті ШІ. Хоча ймовірність витоків індивідуальних записів низька, майбутні атаки можуть виявитися більш серйозними.

- #ШІ

- #АI

- #конфіденційність

2024-11-22 10:46:59